系统一、系统二

最近因为上了“决策与推理”课,我又开始重读《思考,快与慢》,重读期间体会愈加深刻。

我常常在学习中感受到书中提到的两种思维模式的拉扯:一方面是快速直觉的判断(即卡尼曼所说的“系统一”思维),另一方面是需要深度思考、仔细权衡的慢速理性分析(“系统二”思维)。

一般来说在课堂上,老师提出问题时,我的大脑会条件反射地蹦出直觉答案,有时候这个直觉很准,但有时候会闹出笑话。这种快速直觉判断往往来自以往经验的积累,不假思索,几乎不费力就产生结论;而当问题变得复杂,例如需要解一道新类型的数学题或做一个重大的学业决策时,我才会按捺住冲动,启用深度思考模式,慢慢分析各种信息、条件,再得出答案。

然而,这两个系统有时会发生冲突:直觉给出一个看似简单的答案,但理性分析却告诉我事情没那么简单,需要更全面的信息和逻辑推理。

很有趣的是,书中提到系统二往往比较“懒惰”——如果没有遇到困难,它更倾向于信任系统一给出的答案,省下脑力。

一旦系统二偷懒,我们可能就过于依赖知觉,导致判断失误。也就是说,我们人脑喜欢走捷径,并且我们还常常没意识到,系统一就已经给出答案了。而系统二若不及时介入核查,可能让我们误以为直觉就是正确答案。

我记得最清楚的场景是在一次小组讨论中,我们需要快速决定选题方向,我凭直觉选择了一个听起来最熟悉的题目,其他同学也都同意。但是后来深入研究,才发现这个方向资料匮乏、论证困难,我们当初直觉判断有偏差,导致后来付出了更多时间来弥补。

不意味着系统一就不重要或者系统二总是正确,在许多创造性活动中,直觉和发散思维(系统一)非常关键,它能带来灵感的火花;而理性思维(系统二)则将这些灵感付诸逻辑的检验和执行。

一个生动的比喻是:系统一好比飞奔的赛车,速度惊人但有时会偏离轨道;系统二则像冷静的导航员,为赛车指明方向但步调缓慢。

我们需要学会同时扮演好赛车手和导航员的角色:平日里通过学习和实践不断训练自己的直觉,让它在专业领域变得更敏锐可靠;关键时刻懂得按下“慢速思考”的按钮,让导航员接管驾驶,确保我们沿着正确的道路前进。

何时快?何时慢?

系统一 vs 系统二:何时用快,何时用慢? 卡尼曼强调,理想的状态是让两个系统搭配合作,各展所长。对于大多数日常琐事或我们非常熟练的任务,可以放心依赖系统一的直觉,这样既节省脑力又足够用。

我在英语听力练习时,常常依靠直觉反应去听懂大意,不刻意逐词翻译,这反而提高了理解速度。当面对高风险或重要的决策时,就必须果断启动系统二来把关。

大二的时候,我在考虑是否辅修一门新的专业:起初直觉告诉我“这门课很热门,大家都在学,我也应该跟风报”,但冷静下来后,系统二让我列出了辅修的利弊、时间投入和自己兴趣所在,最后发现仅仅因为流行就跟风选择并不明智。

在这个过程中,系统一给出了快速的情绪化建议,而系统二通过深思熟虑纠正了最初可能的冲动。卡尼曼在书中形象地说:“系统1编了一个故事,系统2相信了这个故事”——意思是系统一往往会快速给出一个我们愿意接受的结论,而如果系统二偷懒不加审视,我们就会被这个“太快得出”的故事蒙蔽。

我们需要训练自己识别哪些情境容易出错,并及时让系统二接管。例如当直觉判断觉得某考试题目“好简单,一看就会”,反而更要谨慎,认真审题计算,避免由于想当然而失分。系统一管日常熟练事务,系统二应对异常复杂挑战,正是两种思维模式的最佳配合。

判断问题重要性

在学习中,我现在尽量做到:简单问题信任直觉,重要问题慢慢思考。但是怎么算简单怎么算重要?看似简单会不会实际很重要?

一般来说,我首先看“代价”,错误带来的后果是否严重。如果问题的结果可能带来严重后果或影响范围较大,就要慎重考虑;如果出错的代价低、不易产生长期负面影响,则可以更灵活地依赖直觉。

第二个是“熟悉度”,对问题情境是否有足够的以往经验。系统一(直觉)相对擅长在“熟悉环境”下做出快速且大概率正确的判断;如果你对某领域经验不足,或者问题超出你的知识与经验边界,最好不要轻易相信直觉。

系统二思考会更加耗费认知资源,不可能也不现实对所有问题都深究到底。我们需要经济地分配自己的脑力:在哪些问题上值得花大精力思考,在哪些问题上可以“差不多就好”?

一般来说,以上两个是我们自然而然就会发生的,可能都不需要注意,我们大脑就自动加工了。我认为需要注意的是“可检测信号”,是否有任何警示在提醒“问题没那么简单”。

卡尼曼提出,当系统一面临“无法处理的情境”时,往往会出现某些预警信号(如疑惑、迟疑、不适感),告诉我们“情况不对劲,需要系统二介入”。在学习或日常生活中,如果直觉判断让你感到不安、或者隐约觉得哪里不对,却又说不出原因,就说明可能要更多关注。

最后就是找反例,主动寻找不同视角或质疑,以确认问题究竟难不难。我们的直觉往往会在第一时间“告诉”我们这个问题简单或不简单,但有时这是确认偏误在作祟。如果你想区分真实的“简单”与“假简单”,可以刻意去找反例或让别人帮你提问,从而测试是否真的这么容易。

不必追求对“简单”或“重要”做出100%精确区隔,毕竟现实很少有绝对清晰的分界。把握基本原则后,允许自己存在一定冗余:宁愿偶尔“多想一下”,也比频繁误判要好。总结一个省流版:主动审视,动态调整,适度冗余。

认知偏差和学习效率

卡尼曼的研究揭示,人类直觉思维(系统一)在带来高效的同时,也容易受到一些心理偏差(比如我们刚提到的确认偏误)的影响。这些偏差如果不加以克服,会直接影响我们的学习效率和决策质量。根据我个人的个人生活经历,我感觉最常见的就是锚定效应、确认偏误和过度自信。

锚定效应

锚定效应指人们在做判断时,过分依赖最初获得的信息(锚),即使该信息不够准确,后续的调整也往往不充分,导致最终判断偏向这个“锚”。换句话说,我们的直觉很容易被第一个出现的数字或概念影响。

在一次决策推理课堂实验中,老师先问“甘地去世时是否超过144岁?”这个荒谬的问题其实是在给出一个很高的数字作为“锚”。接着问“那你认为甘地去世时是多少岁?”结果许多同学给的答案明显受到144这个数字影响,都估得偏高。尽管大家知道人不可能活到144岁,但这个高锚定仍潜移默化地拉升了我们的估计值。

卡尼曼的研究指出,锚定效应与系统一和系统二都有关联:系统一受到启动效应的影响,也就是一开始那个锚(无论合理与否)激活了我们脑中的某些联想;而系统二本该负责校正,但常常调整不足,没有完全摆脱锚的影响。

再到 AI 的使用场景,当我们用ChatGPT搜索资料时,它给出的第一个回答往往会对我们产生锚定。如果ChatGPT最初提供了一个论点或数据,我们可能接下来寻找资料都会围绕它展开,甚少去大幅偏离最初的信息。

尤其当在写论文时询问AI某个问题,如果AI最初的回答看似有道理,我们就容易盲目相信这个初始信息,后续即使查证也可能带着倾向性去验证,而不是客观审视。锚定效应会导致我们的决策缺乏弹性,过早收敛在一个狭窄范围内。

那该怎么应对锚定效应?

首先,要有意识地在关键决策时主动激活系统二。当看到可能带有锚定效应的数字或信息时,提醒自己“这可能是个锚”,进而质疑这个初始值的合理性。在我的实践中,我会刻意多问几个“为什么是这个数字?”、“有没有相反的可能?”来逼自己跳出锚的束缚。

其次,可以寻求多个独立的信息来源。不要让单一来源(尤其是AI给出的单一答案)成为唯一依据。比如,上次我在做一个市场调研报告时,ChatGPT告诉我“中国某行业市场规模约100亿元”。我感觉这数字像是随口给的,于是又去查了行业协会的数据报告,结果真实数字不到50亿——如果当初被ChatGPT的回答锚住,报告结论将大相径庭。

卡尼曼也建议,在判断时应该设定一个区间或者上限,不要被单点锚死。例如,当需要对某事做数量估计时,先参考基准值,再考虑各种因素进行上下调整,而不是接受脑中冒出的第一个值。

如果已经意识到被锚定,可以二次思考重新估计:假装自己没见过那个锚信息,从头客观评估一次,看两次结果差异在哪。通过这些方法,我们可以削弱锚定效应对学习和决策的干扰,让判断更接近事实。

确认偏误

确认偏误,简单来说就是只看见想看的,指人们倾向于寻找、解读支持自己已有信念或假设的信息,而忽视或低估与之相矛盾的信息。这种偏差让我们在信息的海洋中选择性地“视而不见”:只听自己愿意相信的,自动过滤掉不符合预期的证据。

当我们脑中已经有一个先入为主的想法时,系统一会通过联想机制不断强化这个想法的相关内容,而系统二本该起到审查和质疑的作用,但由于其“懒惰”属性,很多时候并不会积极去挑战系统一给出的结论。

锚定效应可以和确认偏误放一块看,你被第一个信息锚定住了之后,如果再来一个确认偏误,那你大概率就被第一个概念困住,然后围着他一直转。

正如书中提到的,当我们问“山姆是不是很不友好?”这样的提问方式,本身就带有倾向性,会引导系统一搜寻山姆不友好的例子。如果没有强大的系统二来不信任这种暗示,我们很容易就此认定“是啊,山姆不太友好”。

社交媒体和推荐算法有“信息茧房”的效应,会根据我们以往的选择推送相似内容,使我们更难接触到相反观点。这可能会一定程度上加剧我们的确认偏误。在使用像ChatGPT这样的AI助手时,我有时会注意到,如果不提醒它“请提供不同观点”,它往往会给出与我问题预设相吻合的回答,进一步强化了我原本的想法。

如何克服确认偏误?

像卡尼曼所言,“不信任和质疑是系统2的工作”,我们需要刻意调动系统二来扮演“怀疑论者”。当内心很快对一件事下定论时,问问自己:有没有可能我错了?有没有相反的证据?

第二个就是注意信息提问的方式。尽量使用中性而非引导性的问题来检索信息。例如,不要问“是不是A导致了B?”这种默认A有影响的提问,而要问“有哪些因素可能导致B?”。提问方式的中立能帮助我们获得更客观的答案,避免AI或搜索引擎迎合我们的成见。

第三,利用对立观点来校准。可以尝试和持不同看法的同学讨论,或者让ChatGPT分别扮演正反双方展开辩论。通过这种自我辩论,我们能更清晰地看到自己观点的漏洞。

卡尼曼提到“群体智慧的前提是每个人的观察需要独立以排除系统性偏差”。

我们个人也要尽量接触多元的信息渠道,不把鸡蛋放在一个篮子里,去培养独立思考和获取信息的多样性。阅读不同立场的文章、关注不同观点的学者,这些都会拓宽我们的视野,弱化确认偏误的影响。

对于使用 AI 工具,关键在于不要把AI视为权威的最终裁决,而是将其当作启发思路的助手。当ChatGPT给出某结论时,我们可以追问:“有没有反对这种观点的论据?”或者使用不同的提示词让它提供另一种看法。通过来回求证,我们才能走出“只印证自己信念”的舒适区,从而提高学习的全面性和决策的正确性。

认知偏差

最后一个认知偏差是过度自信(我相信大家都见过不少迷之自信的人),他们一般都高估自己的知识水平、判断准确性或对事件的控制能力。简单来说,就是自我感觉过好,认为“我不会错”或“事情尽在掌握”,从而低估了不确定性和风险。

卡尼曼指出,可得性偏差(即人们更容易想起近期鲜明的事件)会让人产生不切实际的信心。比如,我如果某几门课学得顺利,可能就对自己的学习方法盲目乐观,而忽视了不同科目需要不同对策的事实。

如果AI多次给我们满意的答案,我们就可能过高信任AI,甚至觉得“既然AI都这么说,那肯定没错了”,放弃了自己独立思考和验证的过程。这实际上是把AI的能力想得过于完美。之前我身边就有同学写论文完全依赖ChatGPT提供的资料和引文,交稿前都不亲自检查来源真实性,结果导师一核对发现引用文献根本不存在——因为ChatGPT有时会编造似是而非的参考文献(幻觉)。

如何避免过度自信偏差?

古人说“知人者智,自知者明”,认识自己能力的边界是很重要的。因此,保持谦卑和自省。我们可以定期反思,事实往往能给我们一个客观反馈,让我们明白自己并非无所不知。

卡尼曼提到“慢思考”可以帮助减少直觉偏见,对于过度自信的人来说,刻意放慢决策节奏,多收集一些信息和反馈,可以校正认知。也就是说,我们要重视反馈和错误,

卡尼曼在书中提到“回归均值”等统计概念,提醒我们不要因为一两次成功就觉得以后一定成功,因为运气和偶然因素总在起作用。因此,我们还需要拥抱不确定性,承认这个世界充满随机和不可测因素,即使准备充分也可能有意外。

AI 工具与思维模式结合

现在,我们还面临新的变量——人工智能助手。

ChatGPT 等大型语言模型的爆火,让我们可以随时向 AI 寻求建议、获取信息。以ChatGPT为代表的AI对话助手,可以在几秒钟内提供答案,仿佛成了我们大脑的“外包系统一”。我身边不少同学已经习惯在遇到难题时先问问 ChatGPT,或者使用它来润色论文、生成学习计划。

AI如何激发系统一的灵感

系统一擅长发散思维和直觉判断,而有些AI工具天生就具有发散特点。当拿到论文选题时,如果我一时想不到切入点,会让ChatGPT给出几个不同角度的想法。它产出的某些点子可能看似离谱,但这恰恰刺激了我的灵感,让我想到一些新的组合。AI模型由于训练了海量数据,能联想出许多人类可能一时想不到的关联,这对于打破思维定势很有帮助。

我之前看到有人通过提示词让 ai 扮演不同的观众,去测试文章不同的标题吸引力。因为大语言模型数据是整合了网络上的数据,因此他可以模拟互联网上大部分的人。只要我们给出合适的提示词,就可以让他去模拟不同类型的人。在我们做灵感创意类型的任务的时候,我们也可以使用这种方法去让不同类型的人碰撞出一些火花,去激发一些灵感。

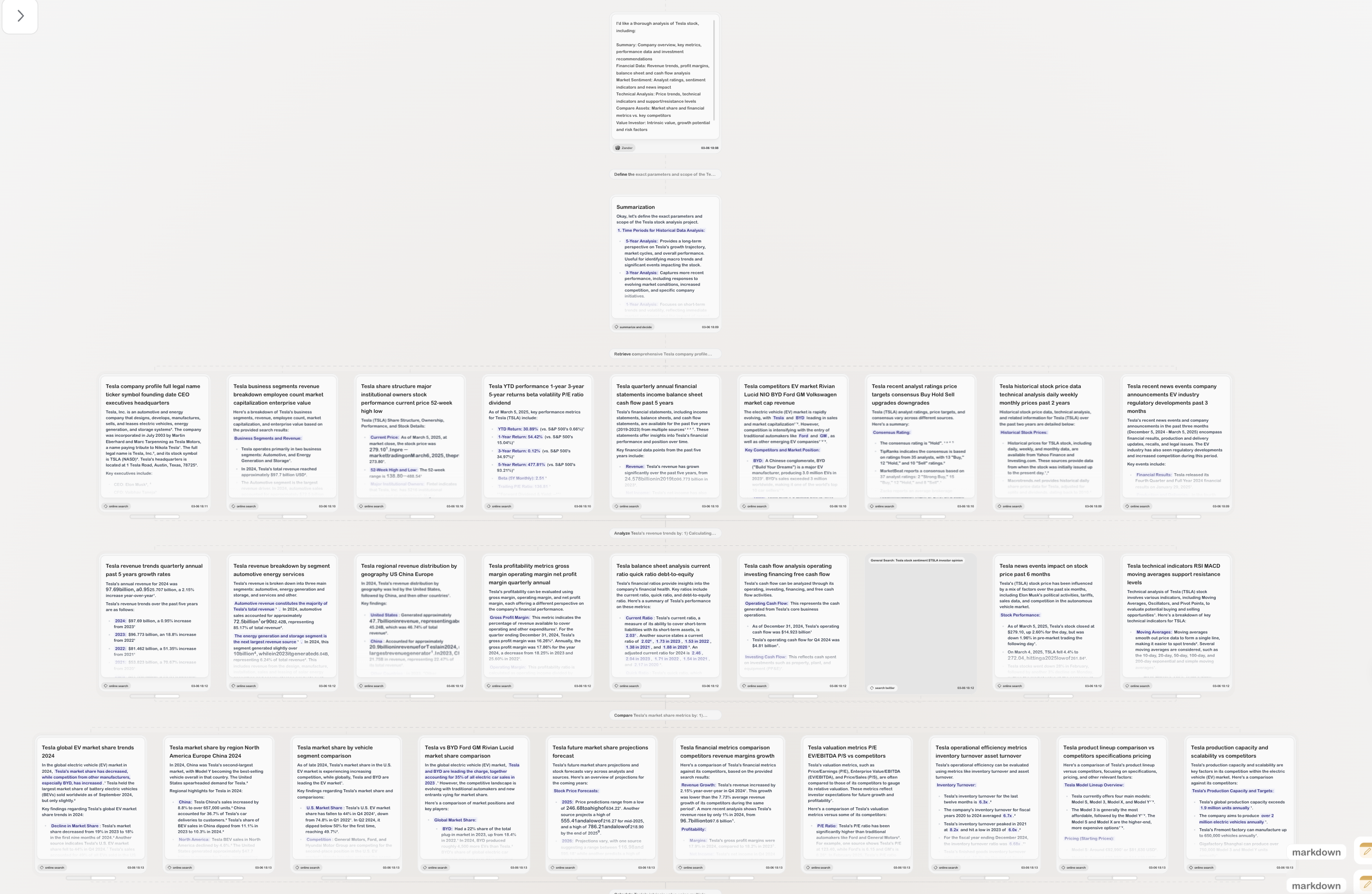

再比如,Flowith AI支持用户在无限画布上跳跃式地连接想法节点,这非常契合头脑风暴和发散思考的流程。我们可以把各种念头拖出来,让AI帮忙展开,然后在画布上重新组合连接。整个过程就像和一个不会疲倦的创意伙伴在进行视觉化的自由联想。这样的互动能促进我们系统一去探索各种可能性,而不必担心走神或遗忘,因为AI已经把每条思路都记录在案。

AI如何增强系统二的能力

一些新兴的 AI 学习工具也涌现,比如 Flowith AI,它采用画布界面和多线程交互,可以让用户在一个界面中同时与多个AI模型互动,帮助我们进行内容创作、任务管理等。这些工具的出现,无疑为我们大学生的学习和决策提供了强大的助力:当系统二感觉吃力时,我们可以借助 AI 快速获取启发和资料,从而提高效率。

我经常把系统二比喻为理性思考的“慢工出细活”。目前的大语言模型,有着强大的信息处理和分析能力,如果加以善用,可以在一定程度上缓解系统二的负担。

我一般把 ChatGPT 当做小伙伴,当我要理解一个复杂理论时,可以先请ChatGPT用简单比喻解释,再进一步提问细节,这样就像和一位全天候在线的导师对话,它能帮助我厘清思路、节省查找定义和例子的时间。

这并非让AI替代我的思考,而是将基础的信息搜集和初步整理交给AI处理(但我们对于信息要谨慎对待),我的系统二则可以把节省下的精力用在更高层次的分析和判断上。尽管我之后仍需核实数据准确性(系统二的把关工作),但有了AI的初步汇总,整个分析流程顺畅得多,我可以更快进入模型分析和结果讨论这些关键环节。

AI工具还擅长提供多样化的视角,特别是现在大语言模型还具备多模态理解和推理能力,这意味着可以让它同时分析文本、图片、数据表格等不同形式的信息,给出综合性的见解。

再如,Flowith AI 这类多智能体代理工具,通过二维画布和多线程对话来组织复杂任务。我将其理解为一种对系统二的扩展:当我面对一个实验设计项目时,可以在Flowith的画布上列出各个子问题节点,与不同模型分别探讨各节点(例如一个模型帮我头脑风暴创意,另一个模型帮我列出调研清单)。这种并行的、结构化的对话过程,相当于把系统二需要线性处理的任务分解并行化了,提高了深度工作的效率。

Flowith还有所谓“Oracle模式”,可以自动为复杂任务规划方案,这听起来像是让AI先扮演系统二拟定一个初步计划,人类再审阅调整。这些例子表明,如果我们善加利用,AI能够在信息整理、模式识别、方案生成等方面增强系统二的能力,帮助我们更全面、更深入地思考问题。

在知识爆炸的今天,人脑系统二有限,我们可以把AI当作认知扩容工具:该记的东西让它记,该算的东西让它算,我们则专注于需要人类洞察力和价值判断的部分。

警惕AI带来的认知偏差

当答案俯首可得,我们是否还愿意费力思考?

有人担心,过度依赖 AI 会不会让我们变得懒于思考,甚至产生新的认知偏差?我也注意到,有的同学写报告几乎全程让 AI 代劳,自己只是简单拼接结果,长此以往会不会削弱我们的深度思考能力?

正如媒体报道所指出的,如果学生一味依赖 AI 工具代写作业,直接选择“躺平”,容易养成思维惰性,不利于批判性思维的发展。

我发现,自从有了像ChatGPT这样的工具后,有时自己思考一些问题不到两分钟就想去求助AI,仿佛大脑有了一个偷懒的借口。这种倾向对系统二而言是致命的,因为它会越来越“不想启动”。长期依赖系统外包给AI,可能导致我们的分析能力退化。

因此在使用AI时,我给自己定了一条规则:凡是学习类的问题,先独立思考或尝试解决至少15分钟,然后才求助AI,且在AI给出答案后,再花时间消化理解,绝不直接照搬。这可以避免我一上来就“躺平”让AI代劳,维持系统二应有的锻炼。

另外还有过度信任和信息误导。AI模型的答复基于概率和已有数据,有时会出现胡编乱造(尤其是语言模型会给出貌似权威却错误的内容)。如果我们不加分辨地接受,就会被错误信息带偏。并且,由于AI回答通常语气肯定且流畅,人更倾向于相信它。这其实是一种权威偏见和过度自信的结合——因为AI“看起来什么都知道”,我们就低估了它出错的概率。

永远对AI的话保留审慎,即使九次里它是对的,也要考虑到可能有一次是错的。还有一点,AI工具可能无意中放大我们的确认偏误。因为我们在与AI交互时,往往是我们提出问题,AI给出回答。如果我们提的问题本身有倾向(比如只问对某观点有利的例子),AI就可能满足我们的偏好,从而让我们更坚定原来的立场。而不会主动提醒我们去看反面。除非我们主动要求,否则AI一般不会自发提供相反的信息。这需要我们在用AI时保持意识:多提开放性问题,让AI从多个角度回答,而不是单线条地验证某种看法。

为了让AI工具真正与我们的思维模式形成良性互补,而不是削弱我们的思考能力,需要一些具体的学习方法和使用策略。

最首先的,是将 AI 当教练而非拐杖,即让AI帮助我们提高,而非一直扶着走。比如在学习编程时,可以用AI来检查和优化自己写的代码,而不是让AI直接写完整代码。通过比对AI优化前后的区别,我们能学到新的技巧。我们可以让AI变成训练师,指出我们的盲点和弱项,我们再自主改进。

第二点就是要明确使用 AI 的边界,事先想清楚,在哪些环节AI可以参与,哪些环节必须自己动脑。比如我在做科研时,会让AI帮忙汇总资料、翻译文献,但研究思路的框架一定要自己来定,因为创新想法不能外包。

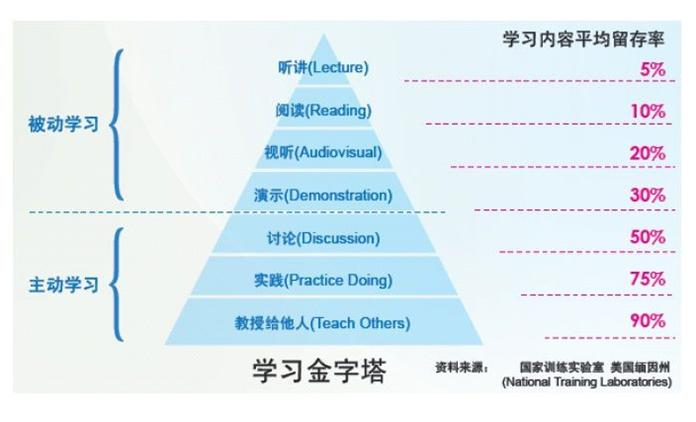

最重要的一点是,利用AI来培养思维而非仅仅求答案。举个例子,我们可以让ChatGPT扮演“提问者”的角色,它来考我问题而不是我问它答案。这样迫使我绞尽脑汁去解答AI的提问,反过来检查自己的不足。这就是他们说的费曼学习法,就是"以教代学",或者说"教是最好的学"。就是你能够用简单的语言向别人解释复杂概念的时候,才表明你是真正理解这个知识。然后学习金字塔理论指出,不同的学习方式的知识留存率,其中教授别人的学习方式留存率最高,达到90%。这也很好地印证了"教是最好的学"这个理论。

反思与总结

透过《思考,快与慢》这本书的启发,我重新审视了自己的学习与决策过程,从中受益良多。作为一名大学生,我深刻认识到理解系统一与系统二的运作规律并加以运用,能够显著优化我的学习方法和日常思考习惯。

回顾这段时间的学习经历,我有几点觉得值得分享:首先就是要认识自己思维的局限,第二就是要在实际的学习中要因地制宜地调用两种思维模式。关键最重要的一点就是在信息时代要学会如何有效利用AI,并保持独立的思考,而不是被它牵着鼻子走。

结合人工智能带来的新机遇和新挑战,我调整了自己的学习方式,让直觉与理性并行,借助AI又不迷失于AI。我相信,只要我们不断在生活中应用所学、反思所行,就能在信息时代锻炼出更敏锐的洞察力和更深刻的思考力,真正做到既能快思,也会慢想,成为学习和决策的主人。